Google, OpenAI in druščina se bodo, če bodo na področju umetne inteligence želeli ostati konkurenčni, naučiti sodelovati z odprtokodno skupnostjo…

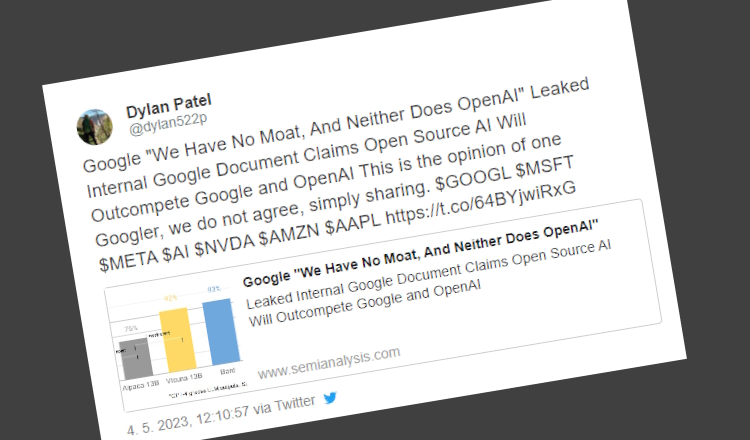

Spletna stran SemiAnalysis je objavila interno pismo višjega Googlovega razvijalca z naslovom "We Have No Moat, And Neither Does OpenAI", ki ga je anonimna oseba delila na javnem strežniku Discord. Razvijalec je prepričan, da je vse večji uspeh odprtokodnih projektov na področju umetne inteligence in obdelave naravnega jezika razlog za to, so veliki igralci na področju umetne inteligence (Google, OpenAI…) v precejšnjih skrbeh.

Kot razlog za to navaja impresivne rezultate brezplačnih jezikovnih modelov, kot je recimo LLaMA podjetja Meta. LLaMA je bil kmalu po objavi objavljen v obliki torrenta in zdaj služi kot podlaga za številne druge modele, kot so Alpaca (Univerza Stanford), Vicuna, LLaVA, Koala (Univerza Berkeley) in še katerega. Ti modeli so v le enem mesecu dobili različice z uglaševanjem navodil (Instruction Tuning), okrepljenim učenjem na podlagi človeških povratnih informacij (RLHF) in celim kupom drugih kakovostnih izboljšav. To modeli so doživeli tako hiter razcvet zaradi nekaterih ključnih inovacij v odprtokodnih projektih, kot na primer Low Rank Adaptation (LoRA), ki je znatno znižal vstopno oviro za usposabljanje in eksperimentiranje, hkrati pa so te tehnike omogočile hitre iteracije, visoko kakovost in nižje stroške. Posledično so odprtokodni modeli povečali konkurenco Googlu, OpenAI in drugim redkim podjetjem, ki so bila pred tem sposobna finančno podpreti razvoj velikih jezikovnih modelov. Ta podjetja se bodo zdaj najverjetneje morala prilagoditi tej novi odprtokodni realnosti in, namesto ohranjanja nadzora nad svojimi modeli, najti načine, kako s to skupnostjo sodelovati.

Nedavni komentarji